Obfuscation de liens SEO – Comment ca marche et comment procéder

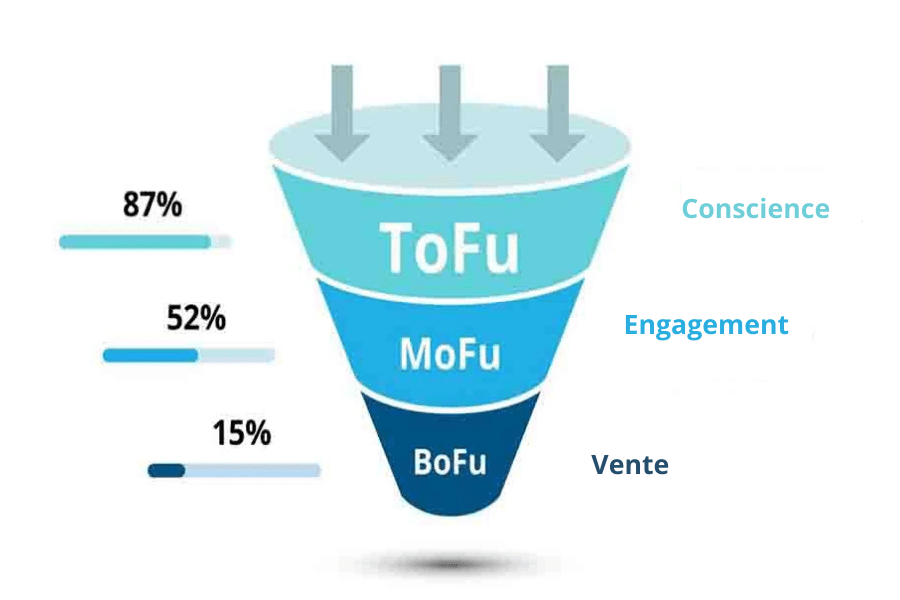

Le référencement naturel (SEO) s’articule autour de l’obfuscation de liens SEO, une technique visant à optimiser la transmission du PageRank, cet indicateur de popularité si précieux pour Google (EAT). Ce PageRank, également connu sous le nom de « jus SEO », se propage d’une page à l’autre comme un héritage d’autorité, essentiel pour booster la visibilité. L’enjeu est de maximiser ce jus SEO sur les pages stratégiques d’un site afin d’en tirer le meilleur parti.

De manière simplifiée, le PageRank se partage entre les différents liens sortant d’une page. Ainsi, une page recevant des liens depuis plusieurs autres pages d’un même site capte du jus SEO de chacune de ces sources qui la ciblent.

Lorsque cette page joue un rôle central sur votre site, cela devient un avantage considérable pour votre stratégie.

À l’inverse, il est frustrant qu’une page peu pertinente bénéficie d’une telle concentration de jus SEO. Comment y remédier ? En masquant ces liens secondaires aux yeux du moteur de recherche, tout en les laissant visibles pour les visiteurs.

Cette approche, appelée obfuscation de liens SEO, soulève des questions. Comment cette technique influence-t-elle le SEO ? Comment la déployer en respectant les consignes de Google ?

Étudions cette pratique, à la croisée de l’efficacité et de la controverse.

Qu’est ce que l’obfuscation de liens SEO ?

Avant d’aborder les détails techniques, concentrons nous sur l’obfuscation de liens SEO, une clé pratique qui s’appuie sur les bases du PageRank. Ce système algorithmique évalue la notoriété d’un site selon les liens externes qu’il tient, définissant ainsi un score global, appelé PageRank interne. Depuis votre page d’accueil, vous partez avec une valeur de 100 %, qui se répartit ensuite entre tous les liens internes présents sur cette dernière. Ce mécanisme se répète ensuite à travers l’ensemble des pages de votre site.

Naturellement, une page peut être connectée par plusieurs autres pages au sein du même domaine. Plus une URL bénéficie de ces connexions internes, plus son PageRank interne grimpe. C’est pourquoi les pages reliées aux menus d’un site sont souvent jugées prioritaires : elles profitent de liens provenant de toutes les autres sections du site. Cette dynamique, essentielle en SEO, nécessite une gestion fine du maillage interne, souvent via une technique appelée PageRank sculpting. En effet, tous les liens de vos pages ne doivent pas nécessairement être visités par les robots de Google. Par exemple, vous pourriez éviter qu’ils s’égarent dans vos filtres à facettes ou qu’ils diluent votre PageRank sur des boutons de réseaux sociaux intégrés dans le footer, présents sur chaque page.

C’est ici qu’intervient l’obfuscation de liens SEO. Certains liens, bien qu’utiles pour guider les visiteurs, n’ont pas besoin d’être visibles par les moteurs de recherche. L’objectif en SEO de l’obfuscation de liens est de préserver leur accessibilité pour les utilisateurs tout en les rendant indétectables pour les robots d’indexation. En d’autres termes, il s’agit de cacher ces liens aux yeux de Google, sans que cela n’altère l’expérience d’un internaute, qui ne percevra aucune différence entre un lien masqué et un lien standard.

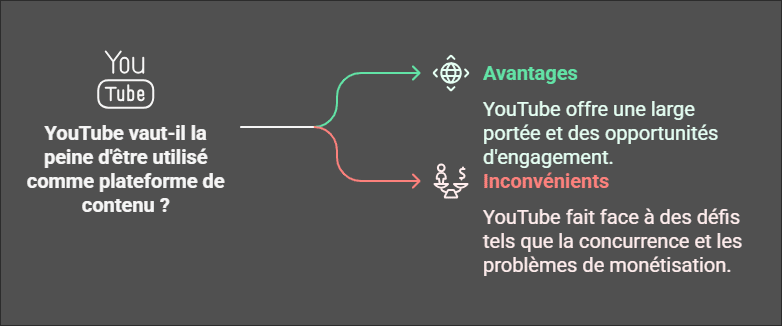

Les avantages de l’obfuscation de liens en SEO

À première vue, cacher un lien aux moteurs de recherche tout en le laissant apparent pour que les utilisateurs puissent sembler déroutants. Pourtant, l’obfuscation de liens SEO offre de multiples avantages, notamment pour optimiser la structure et la performance d’un site.

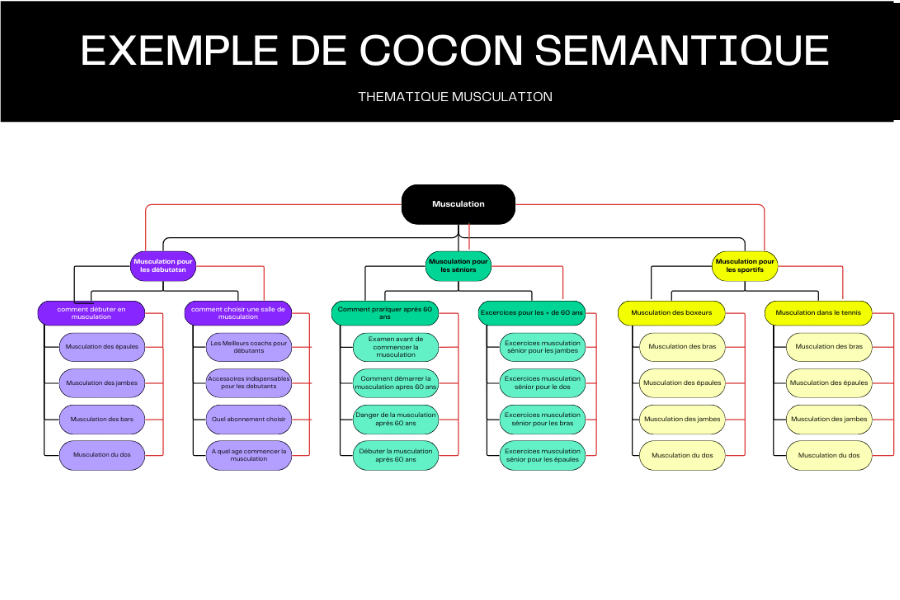

Renforcer la cohérence thématique d’un site

En SEO, le concept de glissement sémantique occupe une place centrale. Cette approche permet d’établir des connexions entre des pages ou des sites aux thématiques distinctes grâce à un mot-clé commun, facilitant ainsi la compréhension des relations par les moteurs de recherche. Avec l’obfuscation de liens SEO, une page A transfère à une page B non seulement sa puissance, mais aussi un cadre sémantique pertinent.

Prenons un cas concret : si la page A traite des chaussures Nike et la page B aborde le football, Google peut interpréter ce lien comme une continuité dans l’univers du sport, associant les chaussures Nike au football. Cependant, sans un maillage interne maîtrisé, comme avec des méga-menus mal gérés, les robots risquent de naviguer entre des pages sans cohérence thématique, ce qui peut nuire au référencement et à l’autorité globale du site. Par exemple, sur une plateforme e-commerce comme Amazon, un lien entre une page « chaussures » et une page « transat » pourrait fragiliser le cocon sémantique, dispersant ainsi la puissance SEO.

Orienter le crawl de Google vers les priorités

Un autre atout majeur de l’obfuscation des lien SEO réside dans sa capacité à influencer le crawl de Google. En dirigeant les robots vers les pages stratégiques, cette technique relègue les sections moins importantes au second plan. Sur une page d’accueil classique, sans obfuscation SEO, des éléments comme les mentions légales ou la politique de confidentialité – souvent placés dans le footer et donc omniprésents – peuvent accaparer autant, voire plus, de poids SEO que des contenus clés. En masquant ces liens aux yeux du Googlebot, les webmasters optimisent l’exploration, concentrent les ressources sur les pages prioritaires et assurent une indexation plus ciblée.

De plus, cette méthode améliore la répartition du PageRank, cet algorithme qui évalue l’importance d’une page en fonction de la qualité et de la quantité des liens entrants. Grâce à l’obfuscation de liens, la distribution de cette autorité devient plus contrôlée, valorisant les pages essentielles au détriment des secondaires. En somme, cela booste les performances des pages à fort enjeu commercial en leur offrant une visibilité accrue.

L’obfuscation de liens SEO pour dépasser les limites du nofollow

Actuellement, les experts SEO déconseillent l’usage systématique de la balise rel=”nofollow” dans les liens, car Google a modifié son interprétation. Autrefois, elle bloquait le suivi du lien et la transmission de puissance ; aujourd’hui, bien qu’elle indique toujours de ne pas suivre le lien, une partie de la puissance est tout de même diluée. Imaginons une page avec une puissance de 100 % contenant deux liens : un en dofollow et un en nofollow. Au lieu de concentrer toute la puissance sur le dofollow, le nofollow gaspille 50 % de cette valeur, correspondant à l’efficacité globale. L’obscurcissement, en revanche, offre une alternative plus fine pour préserver cette puissance tout en contrôlant l’exploration.

L’obfuscation de liens en affiliation

L’obfuscation de liens SEO est une tactique prise dans les sites d’affiliation pour masquer la source des liens à Google, tout en les gardant fonctionnels pour les utilisateurs. Ces sites tirent profit de liens trackés (ex. https://partenaire.com?affid=12345 ) pour rediriger vers des partenaires et générer des commissions. Cependant, ces URL révèlent leur nature affiliée, ce qui peut attirer l’attention de Google et risquer une pénalité si le contenu semble trop commercial.

L’obfuscation de liens vise à rendre ces liens opaques aux robots. Par exemple, une redirection interne (ex. monsite.com/go/partenaire ) peut remplacer le lien brut, masquant la destination via un script ou une règle serveur. Une autre option est l’encodage JavaScript, où le lien est généré dynamiquement, invisible pour les robots qui peinent à interpréter ce code. Ainsi, Google ne détecte pas la source affiliée, protégeant le site d’une classification défavorable.

L’avantage est clair : dissimuler l’intention commerciale tout en préservant l’expérience utilisateur et en limitant la fuite de PageRank vers des sites externes. Mais le risque existe. Si l’obfuscation est trop évident ou viole les consignes de Google (ex. cloaking trompeur), une sanction peut tomber. Pour minimiser cela, il faut enrichir le site de contenu utile (guides, avis) et rester subtil dans l’implémentation.

Pour résumer, l’obfuscation des liens dans l’affiliation brouille les pistes pour Google, optimisant la discrétion et le référencement, mais elle exige de la finesse pour éviter les pièges.

Obfuscation SEO : comment gérer facilement le PageRank ?

Gérer son PageRank avec l’obfuscation de liens, c’est comme cacher certains chemins aux yeux de Google tout en les laissant ouverts pour les visiteurs.

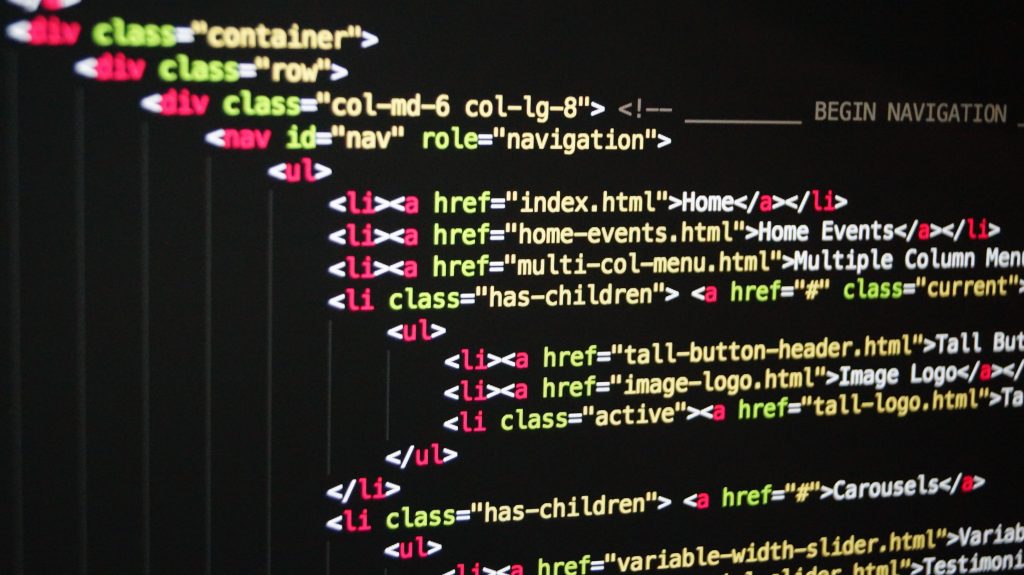

En gros, on utilise des astuces dans le code HTML pour que les robots de Google ne repèrent pas certains liens. Ces derniers deviennent alors invisibles pour eux, même s’ils restent cliquables pour vous.

Pour les utilisateurs, rien ne change : ils voient le lien, cliquent dessus et naviguent normalement. Tout est fluide !

Avec l’obfuscation de liens, le PageRank – cette « force » que Google donne à tes pages – ne se perd pas. Il se concentre sur les liens que les robots peuvent voir, ceux qu’on ne cache pas.

Normalement, un lien en HTML ressemble à ça :

<a href=”http://www.monsite.fr/page”>cliquez ici</a> .

Les robots recherchent ce bout de code pour repérer les liens. L’obfuscation, elle, ruse pour créer des liens (boutons ou autres) sans que Google ne les comprenne.

- Astuce 1 : le bouton HTML

Exemple :

<form action=”http://www.site-caché.com”><input type=”submit” value=”Clique ici” /></form>

Vous cliquez, ça vous emmène sur l’url au site. Pour vous, c’est un lien normal. Pour Google, c’est juste un bouton, pas de PageRank transmis !

- Astuce 2 : JavaScript

<button onclick=”allerAuSite()”>Cliquez ici</button>

<script>function allerAuSite() { window.location.href = “http://www.site-caché.com”; </script>

Vous cliquez, ça marche. Mais Google, qui lit mal le JavaScript, passe à côté.

- Astuce 3 : Base64

On encode un lien (ex. https://www.site.fr/legal/ devient aHR0cHM6Ly93d3cuc2l0ZS5mci9sZWdhbC8= ), puis un script le décode quand vous cliquez. Vous pouvez naviguer sans souci ; Google, lui, ne voit rien.

Quels liens obfusquer en priorité ?

Chaque site a ses particularités, mais certains liens reviennent souvent et méritent d’être cachés aux yeux de Google.

Les liens externes sur toutes les pages

Pensez aux liens vers vos réseaux sociaux ou à l’agence qui a conçu votre site, souvent placé dans le footer. On conseille de les laisser visibles sur la page d’accueil, mais de les obfusquer partout ailleurs. Pas besoin de paniquer avec les liens externes : ils sont parfois utiles, et Google ne vous punira pas pour ça. Il adore les backlinks pour explorer le web !

Les liens typiques des e-commerces

Une boutique en ligne, ce n’est pas comme un site qui cherche des contacts. Les pages de produits regorgent de filtres (taille, couleur, prix…). Tous ces liens de tri doivent être obfusqués pour éviter que Google ne se perde dans un dédale de variations inutiles. Même choisi pour les liens vers le panier, la connexion au compte ou les options perso : cachez-les aux robots !

Les liens vers des pages inutiles pour le SEO

Vos mentions légales ou votre politique de confidentialité sur Google, ça vous tente ? Non, hein ! Ces contenus ne boostent pas votre référencement. Posez-vous cette question : est-ce que je veux voir cette page dans les résultats de recherche ? Si c’est non, obfuscation directe ! Petit bémol : laissez le plan du site visible, ça aide Google à mieux saisir comment vos pages s’organisent.

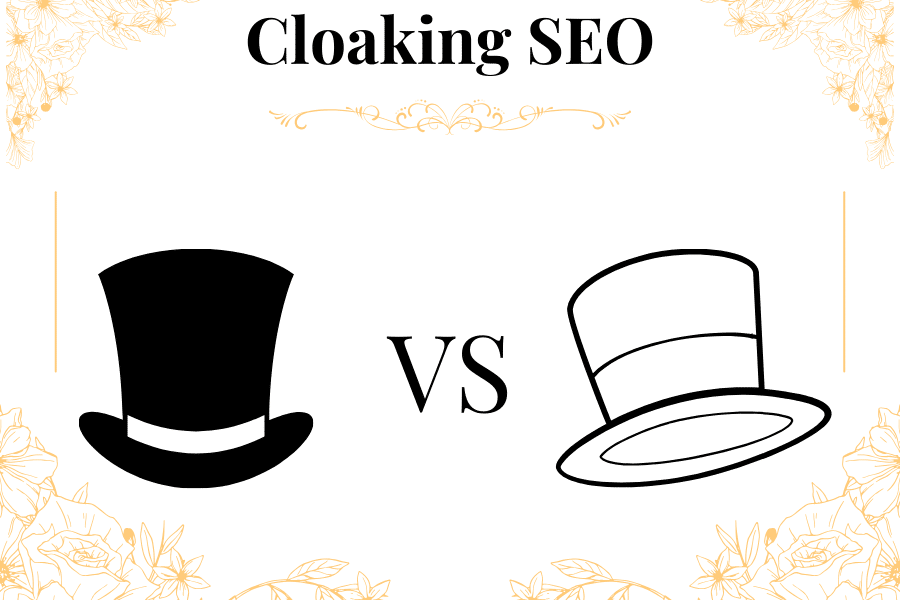

Ne pas confondre obfuscation de liens SEO et cloaking

L’obfuscation de liens SEO est parfois confondue avec le cloaking, une technique un peu louche. Le cloaking, c’est quand un site change de visage selon qui le visite (Google ou toi), en jouant sur l’IP ou le type d’appareil. Ça, c’est du « black hat », pas très propre.

L’idée du cloaking, c’est de montrer à Google une page bourrée de texte, parfaite pour grimper dans les résultats, pendant que toi, tu vois une page sympa avec des images, un formulaire ou des vidéos – trucs pas toujours top pour le SEO. Bref, deux versions bien différentes !

Mais attention, l’obfuscation de liens SEO, ce n’est pas ça. Elle est OK pour Google depuis longtemps, et John Mueller, un gourou du SEO, l’a confirmé. L’obfuscation ne cache pas le contenu, elle guide juste Google vers les pages importantes. Pourquoi ? Parce que faire tourner le Googlebot coûte cher, et si vous l’aidez à bien explorer votre site, vous lui faites gagner du temps et de l’argent. Résultat : il n’a aucune envie de vous pénaliser !

En clair, l’obfuscation de liens SEO, c’est comme dire à Google : « Allez voir là, c’est le plus intéressant ! » sans tricher. Le cloaking, lui, c’est jouer au malin, et ça peut mal finir.