La dimension technique des sites web représente l’un des cinq piliers pour améliorer le référencement de votre site web. Sans les réglages techniques indispensables, vos efforts de contenus, de mots-clés ou de netlinking sont inutiles. Et le premier paramètre technique à vérifier, ce sont les fichiers robots.txt.

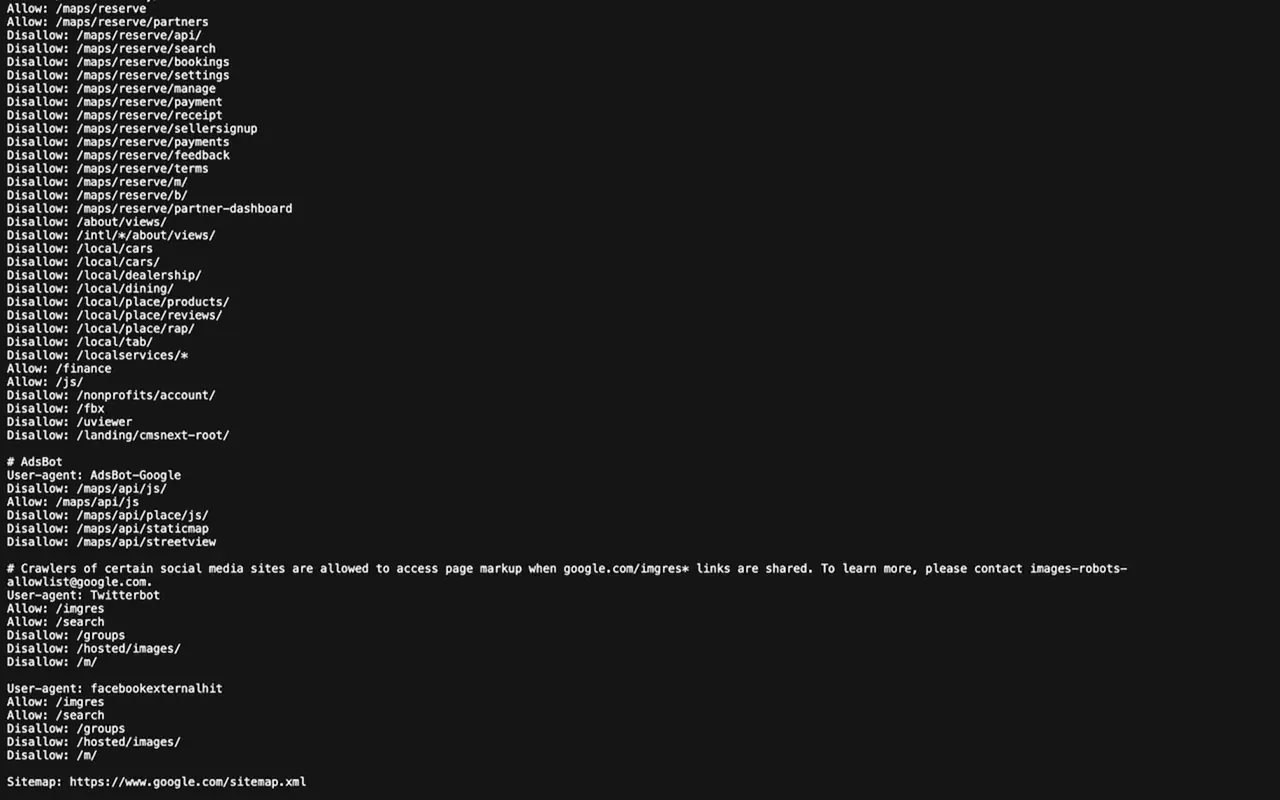

Les robots.txt désignent des fichiers d’instructions pour les moteurs de recherche. Ils indiquent les contenus de votre site web que peuvent visiter les robots d’exploration de Google ou de Bing pour les indexer. Vous devez donc vous assurer que votre site partage des directives correctes. Découvrez l’utilisation des fichiers de robots.txt et leur importance pour votre SEO.

À quoi servent les fichiers robots.txt d’un site web ?

Les fichiers robots.txt précisent le chemin d’accès des contenus à explorer dans le domaine ou dans le sous-domaine des sites internet.

Règles et principes des robots.txt

Par convention, les robots d’exploration ou d’indexation explorent en priorité le fichier robots.txt d’un site. Et selon les instructions de ce dernier, ils procèdent à l’exploration des pages. Ce crawl du site leur permet d’en inspecter le contenu, de l’indexer et de le référencer. Il figure alors dans la grande bibliothèque des moteurs de recherche avec un score de référencement SEO.

Sans instruction, les robots d’exploration Googlebot ou Bingbot scannent tout le site : les contenus à forte valeur ajoutée pour votre SEO et d’autres sans importance pour votre référencement (par exemple une page de paiement). En revanche, si les directives du fichier sont inadaptées, les robots de Google ou de Bing explorent partiellement les pages de votre site internet.

Les avantages pour le référencement SEO de votre site web

Les robots.txt visent à garantir l’indexation des contenus des pages de votre site sur internet. C’est donc un outil indispensable ! Sans cette indexation, aucun internaute ne peut découvrir votre contenu : aucun moteur de recherche ne leur propose.

Le fichier robots.txt permet également d’éviter le ralentissement intempestif de votre site web. En effet, sans instruction, les web crawlers scannent tout votre contenu. Ce temps passé en crawl diminue la vitesse de téléchargement des pages du site. Et ce ralentissement impacte votre référencement SEO.

Les directives des fichiers robots.txt

Le fichier robots.txt se trouve à la racine des sites. Par exemple, pour le site actuel, le fichier réside à l’adresse URL : https://www.seeseo.fr/robots.txt/. C’est là que les directives pour les moteurs d’indexation sont inscrites. Apprenez à les déchiffrer : ce sont des fichiers de texte brut.

La directive User-agent : le type de moteur d’exploration

User agent désigne le nom des moteurs d’exploration : Googlebot, Bingbot, etc.

- la directive User-agent : * signifie que tous les moteurs d’exploration peuvent explorer les pages.

- La directive User-agent : Googlebot signifie que seul le robot de Google est autorisé à scanner le site.

La directive Allow ou Disallow

Allow or Disallow signifient autoriser ou bloquer. Ces directives cadrent le champ d’exploration des robots d’indexation.

- User-agent : * suivi de Allow : / signifie que vous autorisez tous les robots à scanner votre site.

- User-agent : Googlebot suivi de Disallow : /blog indique que seul le robot de Google peut explorer le site sauf son blog.

Si vous constater des problèmes d’indexation dans votre Google Search Console, vérifiez l’état des directives dans votre robots.txt.

La directive sitemap, le guide de votre site

Le sitemap représente le plan de votre site sous le format .xml : véritable guide pour les robots d’exploration, il accélère le scan des pages importantes de votre site. Il renseigne également sur les différentes versions d’une page et ses modifications : langues, mises à jour, etc. C’est donc une aide précieuse au référencement SEO.

Il s’agit donc d’ajouter au fichier robots.txt une ligne avec l’URL du sitemap. Celle-ci indiquera aux robots de Google et Bing les URL des pages à valoriser. Pour le site de seeseo.fr, la directive devient : https://www.seeseo.fr/sitemap.xml/.

La création du fichier robots.txt

La présence de directives facilite le référencement SEO de votre site web. Vous devez donc vérifier sa présence et ses directives. C’est la première étape d’un audit SEO complet. Si vous n’avez pas de fichier robots.txt, vous pouvez demander sa création ou le créer par vous-même.

Utiliser Yoast SEO dans WordPress

Le CMS WordPress propose différents plugins pour gérer votre fichier robots.txt. Le plus connu, c’est Yoast SEO. L’outil vous guide étape par étape pour la configuration du fichier. Yoast SEO propose également la création du sitemap.

Les règles pour créer des directives d’exploration

Si vous souhaitez créer le fichier robots.txt par vous-même. Tenez-compte des bonnes pratiques des développeurs.

- Vérifiez de ne pas bloquer des contenus importants.

- Attention aux liens présents sur les pages en Disallow. Ils ne seront plus suivis.

- Pensez à tester et à valider votre fichier.

Le fichier robots.txt représente donc un outil précieux pour booster votre référencement SEO. Vérifiez son contenu et chaque instruction. Pour bénéficier d’un audit SEO, vous pouvez solliciter notre agence 🙂