Le cloaking SEO, également appelé camouflage en français, désigne une méthode d’optimisation consistant à afficher un contenu distinct selon qu’il s’adresse aux robots des moteurs de recherche ou aux visiteurs humains. Cette technique est souvent adoptée par les gestionnaires de sites internet dans le cadre du marketing digital pour booster leur positionnement dans les pages de résultats et accroître leur trafic naturel. Sa mise en œuvre peut cependant s’avérer complexe et technique. Ainsi, solliciter les services d’une agence spécialisée en SEO peut être une option judicieuse pour appliquer cette pratique dans le but d’optimiser votre visibilité en ligne.

Néanmoins, les moteurs de recherche comme Google pénalisent sévèrement les adeptes des techniques de black hat SEO, parmi lesquelles figure le cloaking. L’objectif de cet article est de vous éclairer sur les implications de cette méthode SEO, de vous permettre de repérer les sites courants aux diverses formes de cloaking et de vous sensibiliser aux dangers qu’elle représente pour votre référencement.

Définition du cloaking SEO

À partir d’une seule URL, deux utilisateurs peuvent se voir proposer des contenus totalement distincts : voilà ce qu’on appelle le cloaking SEO.

Certaines utilisations de cette technique peuvent être considérées comme légitimes pour bien référencer un site web :

- Proposer une page web dans la langue native des visiteurs.

- Ajustez le design ou le format selon le navigateur employé (par exemple, Chrome ou Firefox).

- Afficher des annonces personnalisées en fonction du profil de l’utilisateur.

- Masquer les mots-clés stratégiques d’une page pour éviter qu’ils ne soient exploités par la concurrence.

- Bloquer l’accès aux robots d’indexation des services de messagerie.

En revanche, une pratique jugée « malintentionnée » consiste à tromper les robots d’exploration des moteurs de recherche en leur présentant une version de la page différente de celle visible par les internautes, dans le mais de manipuler les résultats.

Bien que cette méthode pertinente du black hat SEO ait pu, par le passé, améliorer le classement de certains sites, nous vous recommandons vivement de l’éviter. Les moteurs de recherche perfectionnent sans cesse leurs algorithmes pour identifier les sites qui utilisent de ce type de cloaking SEO trompeur, et les sanctions sont déjà en cours. Utiliser cette technique revient aujourd’hui à risquer une mise à l’écart brutale dans le « sandbox » de Google.

Fonctionnement du cloaking SEO

Lorsque vous accédez à une page web, votre navigateur (comme Google Chrome, Mozilla Firefox ou Brave) envoie d’abord une requête HTTP au serveur du site, qui ressemble à ceci :

OBTENIR : /indexfr.php

HÔTE : www.seeseo.fr

USER_AGENT=Mozilla/4.0 (compatible ; MSIE 6.0 ; Windows XP ; GRATUIT)

REFERRER= http://www.google.com/search?hl=fr&q=seeseo+fr=

REMOTE_ADDR=256.74.16.01

Dans cette requête, GET indique le nom de la page demandée (ici, index.php).

HOST désigne le domaine hébergeant cette page.

USER_AGENT représente l’identifiant de votre navigateur (par exemple, Internet Explorer 6 sous Windows XP via Free.fr).

REFERRER révèle la provenance de votre visite (dans ce cas, une recherche Google avant d’arriver sur seeseo.fr).

REMOTE_ADDR correspond à votre adresse IP.

Une fois cette requête reçue, le serveur du site prépare (pour les pages HTML) ou produit (pour les pages PHP) le contenu demandé, puis le transmet à votre navigateur pour affichage, vous permettant ainsi de consulter la page.

Grâce à l’adresse IP, il est possible d’identifier le pays de l’utilisateur, mais aussi de détecter si un robot d’indexation est à l’œuvre. Certains sites maintiennent une base actualisée des IP des principaux robots pour les repérer facilement, une pratique courante chez les adeptes du cloaking SEO. Ces derniers peuvent alors créer des pages bourrées de mots-clés, destinées uniquement aux robots, pour donner l’illusion d’un contenu particulièrement riche.

Cette méthode nuit gravement à l’expérience utilisateur : imaginez chercher « voitures » et atterrir sur un site pour adultes sans aucun rapport. Face à ce problème, il est compréhensible que les moteurs de recherche renforcent leurs efforts pour contrer ce type de manipulation.

Les différentes techniques de cloaking SEO

Plusieurs méthodes de cloaking SEO existent, certaines étant plus subtiles et complexes à repérer que d’autres.

Le cloaking SEO basé sur le user agent

La technique du cloaking SEO via le user agent est très courante, bien qu’elle soit parmi les plus périlleuses. Elle consiste à analyser l’identifiant du visiteur (user agent) pour personnaliser le contenu affiché. Par exemple, si le système détecte un utilisateur humain plutôt qu’un robot, il proposera une page adaptée à ce dernier, avec peu de texte et des visuels sélectionnés. À l’inverse, si un robot est identifié, une version truffée de texte optimisée lui sera servie. Pourquoi un tel effort ? Parce que concilier SEO et expérience utilisateur (UX) peut s’avérer ardu. Pour bien se positionner, une page doit offrir un contenu riche et pertinent, ce qui demande un savoir-faire en conception web pour éviter un rendu trop lourd. Créer deux versions distinctes – une esthétique pour les humains et une textuelle pour les robots – est souvent plus rapide. Cependant, cette pratique perd du terrain, car les robots, notamment grâce au CSS, la détectent facilement.

Le cloaking utilisant l’adresse IP

Chaque internaute se connectant à un site possède une adresse IP liée à sa localisation et son fournisseur d’accès. Cette adresse, visible dans les logs sous forme de chiffres, permet au cloaking SEO par IP d’adapter le contenu selon les données qu’elle fournit. Cette approche sert fréquemment à personnaliser une page en fonction de la région de l’utilisateur. Elle peut également identifier un robot d’indexation pour lui présenter une page ultra-optimisée, incitant ce dernier à juger le contenu comme pertinent et à le valoriser dans les résultats de recherche.

Le cloaking via Javascript, Flash ou DHTML

Cette méthode exploite les spécificités des navigateurs. Si un utilisateur dispose d’un navigateur compatible avec JavaScript, il verra une version différente de celle proposée à un autre ayant désactivé cette fonctionnalité. Cependant, cette technique devient obsolète : aujourd’hui, la question de l’activation de JavaScript est rarement pertinente, et l’utilisation de Flash a presque disparu.

Le cloaking à l’ancienne avec du texte masqué

Considérée comme la plus rudimentaire et risquée, cette pratique repose sur l’ajout de texte invisible (par exemple, en blanc sur fond blanc) dispersé sur la page. Si elle était efficace il y a une décennie ou plus, elle est désormais dépassée et à bannir absolument. Google excelle à repérer ces subterfuges, notamment parce que le CSS, sauf instruction contraire dans le robots.txt (à éviter), est accessible aux robots, qui démasquent facilement ces ruses.

Le cloaking par HTTP_REFERER et HTTP Accept-Language

Cette approche examine l’en-tête HTTP_REFERER de la requête pour déterminer la provenance du visiteur et proposer une version adaptée de la page. Une autre variante analyse l’en-tête HTTP Accept-Language afin d’ajuster le contenu selon la langue préférée de l’utilisateur, offrant ainsi une expérience sur mesure.

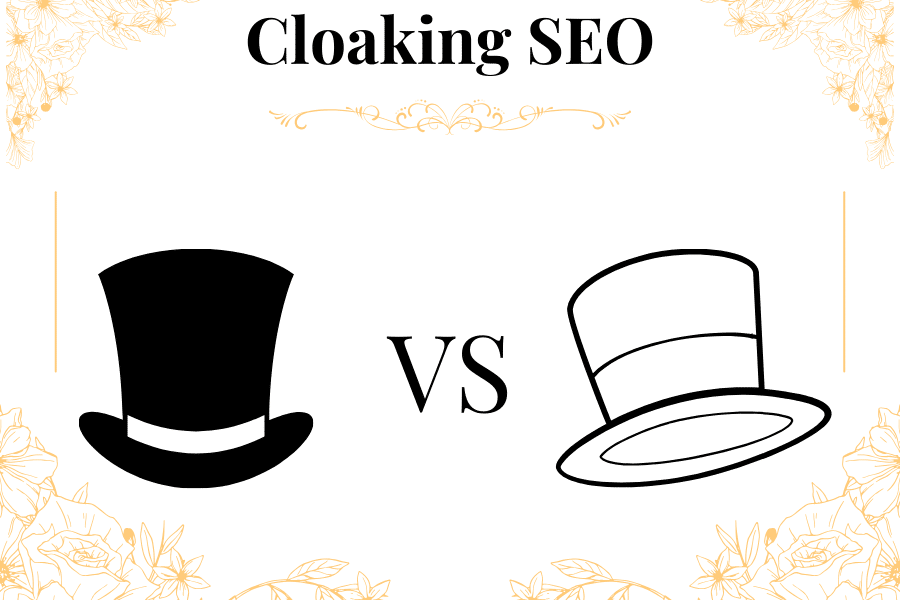

Différences entre le cloaking SEO et l’obfuscation SEO

Le cloaking SEO et l’obfuscation SEO sont deux techniques distinctes, souvent confondues, mais avec des objectifs et des méthodes bien différentes.

Le cloaking SEO consiste à afficher un contenu différent selon le visiteur. Par exemple, un robot de Google pourrait voir une page remplie de mots-clés optimisés pour grimper dans les résultats, tandis qu’un humain voit une version simplifiée avec des images ou des pubs. C’est comme servir deux plats différents au même restaurant : un pour tromper le critique gastronomique, un autre pour les clients. Cette pratique peut être éthique (white hat), comme adaptateur une langue selon le pays, ou malhonnête (black hat), pour manipuler les moteurs de recherche, ce qui risque des pénalités.

L’ obfuscation SEO , elle, cherche à cacher ou brouiller des liens. Cette méthode est utilisée pour maitriser parfaitement la dissolution de “jus SEO”. Par exemple, il peut être judicieux d’obfusquer certains liens d’un méga menu. Dans le cas de site d’affiliation, cette technique est utilisée pour cacher les liens d’affiliation.

Le cloaking en SEO : White Hat vs Black Hat avec exemples

Le cloaking SEO est une technique qui consiste à afficher un contenu différent selon que le visiteur est un utilisateur humain ou un robot d’indexation. Si cette pratique peut être utilisée de manière éthique (white hat) ou manipulative (black hat), ses implications pour le référencement varient considérablement. Étudions ces deux approches avec des exemples concrets.

Le cloaking SEO White Hat : une personnalisation au service de l’utilisateur

Le cloaking SEO white hat repose sur des intentions légitimes visant à améliorer l’expérience utilisateur tout en respectant les directives des moteurs de recherche comme Google. Voici quelques cas d’application :

- Exemple 1 : Adaptation linguistique

Un site e-commerce international détecte l’adresse IP ou l’en-tête HTTP Accept-Langue d’un visiteur. Si un utilisateur se connecte depuis la France, il voit automatiquement la version française du site avec des prix en euros, tandis qu’un visiteur américain accède à la version anglaise avec des prix en dollars. Les robots d’indexation, eux, reçoivent une version standardisée (souvent en anglais) pour éviter toute confusion dans l’indexation. Cette pratique améliore l’accessibilité sans chercher à tromper. - Exemple 2 : Contenu selon le périphérique

Un site adapte son affichage selon le type d’appareil. Un utilisateur sur mobile reçoit une version allégée avec des images compressées pour une navigation rapide, tandis qu’un robot d’indexation (comme Googlebot) obtient une version complète pour analyser tout le contenu. Cela garantit une bonne expérience utilisateur sans altérer la pertinence pour le SEO.

Ces techniques sont considérées comme SEO white hat car elles privilégient l’utilisateur et restent transparentes vis-à-vis des moteurs de recherche.

Le cloaking SEO Black Hat : une manipulation risquée pour duper les robots

À l’opposé, le cloaking SEO black hat vise à tromper les moteurs de recherche pour obtenir un meilleur classement, souvent au détriment des visiteurs. Voici des illustrations :

- Exemple 1 : Contenu optimisé pour robots uniquement

Un site de vente de produits high-tech détecte le user agent d’un robot (comme Googlebot). À ce dernier, il présente une page saturée de mots-clés tels que « meilleur ordinateur portable 2025 » ou « PC pas cher », avec un contenu long et optimisé. Mais un humain, lui, atterrit sur une page minimaliste avec peu de texte, des pop-ups publicitaires et des liens douteux. Cette manipulation cherche à booster le classement sans offrir de valeur réelle aux utilisateurs. - Exemple 2 : Texte invisible pour gonfler la densité de mots-clés

Un blog sur le fitness insère du texte en blanc sur fond blanc, invisible pour les humains, mais bourré de termes comme « perte de poids rapide » ou « régime miracle ». Les robots, capables de lire le code source, d’indexer ce contenu et de juger la page pertinente, alors que les visiteurs ne voient qu’un design épuré sans rapport. Bien que populaire il ya des années, cette méthode est aujourd’hui rapidement détectée et sévèrement pénalisée par Google.

Cloaking SEO White Hat vs Black Hat : les enjeux

Le cloaking SEO white hat mise sur la personnalisation utile et reste dans les clous des recommandations SEO. Par exemple, adapter une page à la localisation ou au périphérique est une pratique acceptée, tant que le contenu reste cohérent pour tous. À l’inverse, le cloaking SEO black hat joue sur la tromperie, ce qui peut entraîner des sanctions comme une chute dans les résultats de recherche ou un retour dans la sandbox.

En conclusion, si le cloaking SEO white hat peut être un atout pour l’expérience utilisateur, le cloaking SEO black hat est un pari risqué. Avec des outils comme Google Search Console et des algorithmes toujours plus performants, les pratiques malhonnêtes sont de moins en moins viables. Pour un référencement durable, mieux vaut privilégier la transparence et la qualité.